Il mondo che ruota intorno ai modelli generativi ci ha abituato a una fortissima accelerazione. Tanto che oggi, spesso, c'è difficoltà nel rimanere aggiornati e la sensibilità nella percezione dell'impatto che potrebbe derivarne tende a scendere.

In questo post affronteremo alcune novità che riguardano principalmente l'ecosistema di OpenAI, che potrebbero essere un vero e proprio game changer se consideriamo un disegno più ampio e proiettato verso il futuro.

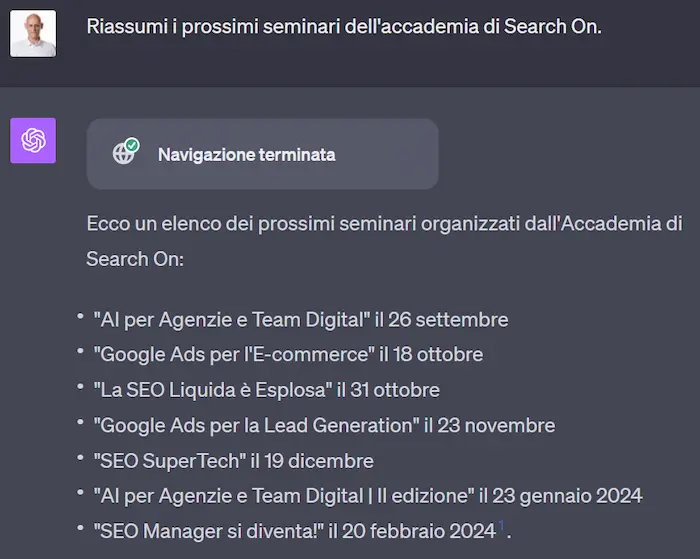

Web Browsing di ChatGPT

Si tratta di una funzionalità di ChatGPT attraverso la quale il sistema, in fase di elaborazione del prompt, effettua le seguenti operazioni:

- esegue delle query su Bing per determinare i risultati più rilevanti;

- esplora i risultati per estrarre le informazioni utili a rispondere alla richiesta dell'utente.

Come vediamo nell'esempio, per dare informazioni aggiornate, il sistema cerca online e organizza la risposta alla domanda che ho posto. Da notare anche che, per ogni parte della risposta, vengono forniti i riferimenti cliccabili che conducono alle fonti.

Per i più attenti e aggiornati, la funzionalità era già presente nelle fasi di sviluppo iniziali di ChatGPT, ma è stata successivamente "messa in pausa" a causa di problemi di sicurezza.

Questa modalità rappresenta anche un ulteriore esempio di come un ibrido tra motore di ricerca (modello di conoscenza) e modello di linguaggio possano essere una delle vie per la ricerca del futuro.

Perché si tratta di un cambiamento importante?

Il ritorno della funzionalità su ChatGPT rappresenta un grande passo per due motivi.

1) Fact-checking automatico

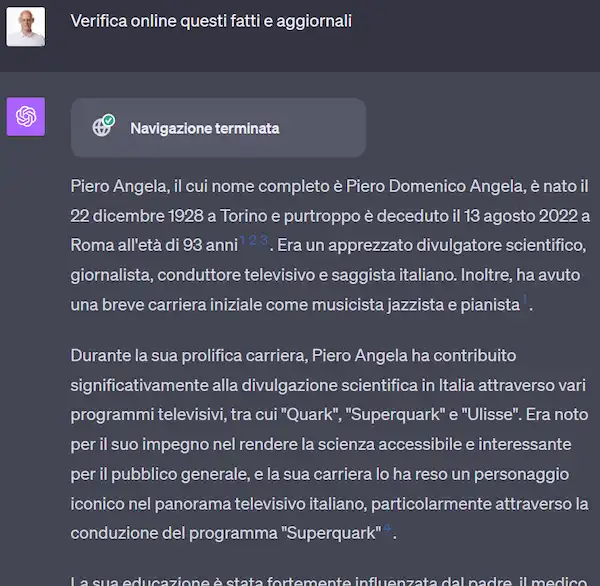

I modelli di linguaggio, in alcuni ambiti, possono produrre informazioni imprecise, errate o non aggiornate. Grazie a questa funzionalità direttamente in piattaforma, possiamo verificarle immediatamente.

Se chiediamo a ChatGPT "chi è Piero Angela?" il modello produce una risposta non aggiornata, che non comprende alcuni fatti a causa della mancanza di informazioni, ad esempio non indica la morte del noto personaggio. Ma se facciamo una richiesta di verifica e aggiornamento delle informazioni, possiamo ottenere una risposta completa.

Di certo Bard di Google lo fa in maniera molto più interessante dal punto di vista della User Experience, ma per ora, solo in lingua inglese.

🧠 #Google ha aggiornato #Bard potenziandolo e velocizzandolo.

— Alessio Pomaro (@alepom) September 20, 2023

💡 Trovo interessante la funzionalità del controllo delle informazioni online. #AI #IntelligenzaArtificiale #chatbot #LLM #GenerativeAI pic.twitter.com/KzaIHXVoRM

2) Un assistente personale "nelle nostre tasche"

Se l'obiettivo di OpenAI è quello di creare un assistente personale per gli utenti, l'estrazione di informazioni aggiornate dal web non poteva mancare. Non a caso, dopo il rilascio, la funzionalità è stata immediatamente integrata nell'applicazione mobile.

DALL-E 3 su ChatGPT

Non solo OpenAI ha aggiornato il suo noto modello generativo dedicato alle immagini, ma l'ha anche integrato su ChatGPT.

Inutile dire che la qualità dell'output è stata incrementata di molto rispetto alla versione precedente, ma questo vale per tutti i sistemi più conosciuti. Anche Adobe, ad esempio, ha seguito immediatamente OpenAI rilasciando Firefly 2, e come si vede dal seguente esempio, che alterna immagini generate dai due modelli, gli output sono impressionanti.

Gli elementi di cambiamento, tuttavia, non derivano dall'aumento della qualità (che segue il naturale corso di ottimizzazione dei modelli), ma dall'integrazione con un ambiente (ChatGPT) che genera una nuova esperienza di utilizzo.

Non si tratta più di un'interfaccia che permette di inserire un prompt per produrre l'output, ma è l'inizio di un sistema più evoluto che può produrre immagini in base a un contesto che deriva dalla conversazione, da fonti esterne, da altre immagini, da altri dati.

Possiamo, ad esempio, generare un contenuto processando un video di YouTube e altre risorse presenti online attraverso GPT-4, e generare delle immagini partendo da tutto il contesto a disposizione.

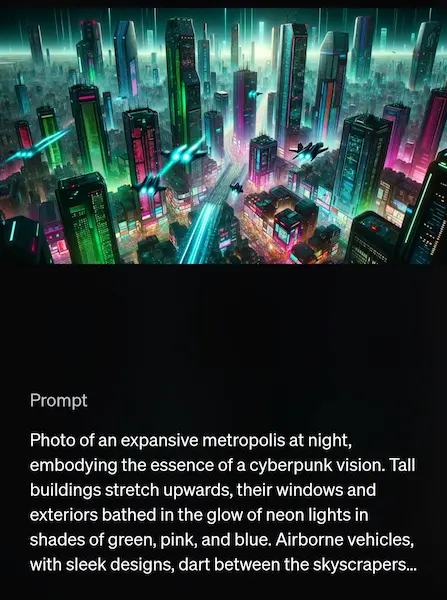

Ma non solo. Un altro aspetto disruptive che deriva dall'integrazione è rappresentato dall'azione che avviene dopo aver inserito il prompt su ChatGPT. Il sistema, infatti lo rigenera (in 4 versioni diverse) per renderlo più performante per il modello. Nelle immagini che seguono, ne vediamo un esempio.

DALL-E 3, infine, come scrive OpenAI nella presentazione, "può rappresentare accuratamente una scena con oggetti specifici e le relazioni tra loro". Né Midjourney, né Stable Diffusion oggi possono arrivare a un dettaglio tale. Non parlo di qualità dell'output, ma di elaborazione della richiesta.

Il seguente post di Jim Monge mette a confronto proprio questi tre modelli arrivando alla stessa conclusione.

Ci si sta avvicinando a vere richieste in linguaggio naturale? Per "vere" intendo richieste in cui ci esprimiamo davvero naturalmente, e non "in modo che la macchina comprenda".

ChatGPT Vision

La nuova funzionalità permette di integrare degli elementi visuali al prompt testuale, con delle capacità di rilevazione degne di nota.

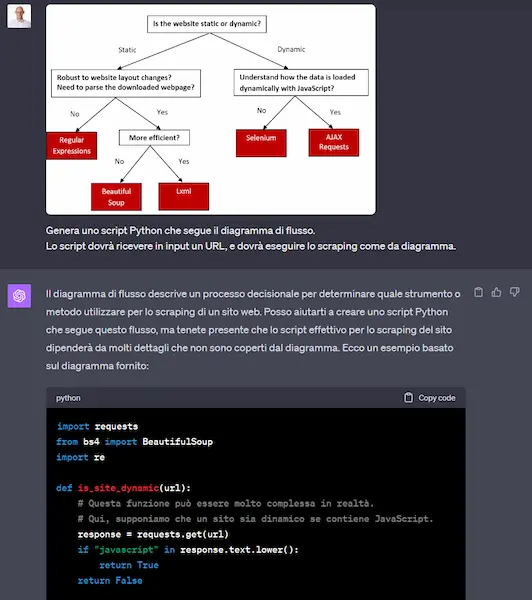

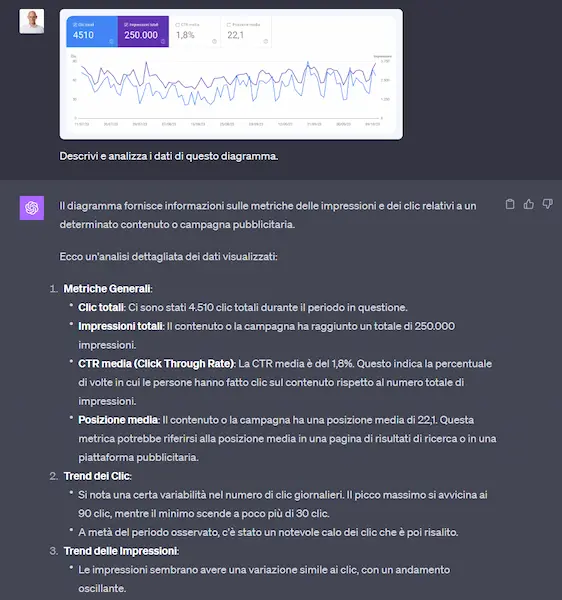

Quelli che seguono sono 3 esempi di sperimentazione che ho realizzato:

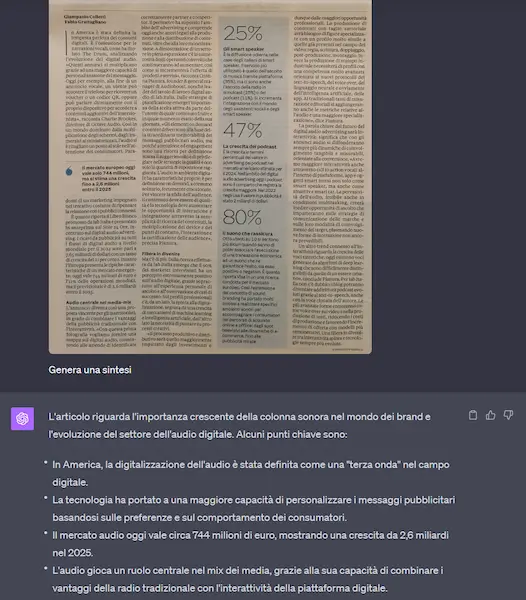

- l'estrazione e la sintesi di un articolo di un quotidiano;

- la lettura di un diagramma di flusso e la trasformazione in codice Python che esegue le operazioni del flow chart;

- la descrizione di un diagramma di Search Console.

Perché Vision di ChatGPT è "game changer"?

Ci avviciniamo sempre di più a un'interazione multimodale con degli assistenti in grado di elaborare diversi input, che insieme formano un contesto evoluto. Questo, potenzialmente, permetterà di avvicinarsi sempre di più a un output che rispecchia gli obiettivi desiderati.

Se uniamo anche questo aspetto al concetto di applicazione mobile, le potenzialità dell'"assistente in tasca" aumentano. L'assistente ha sempre più "sensi" sui quali contare per comprendere le nostre richieste. Abbiamo iniziato a prendere confidenza con questo tipo di interazione con Multisearch di Google, in cui, partendo da un'immagine rilevata con Lens, possiamo aggiungere elementi testuali per perfezionare la ricerca, ma con la tecnologia a disposizione oggi, è possibile andare oltre.

Per non parlare dei risvolti che si potranno avere in ambito dello studio e dell'apprendimento.

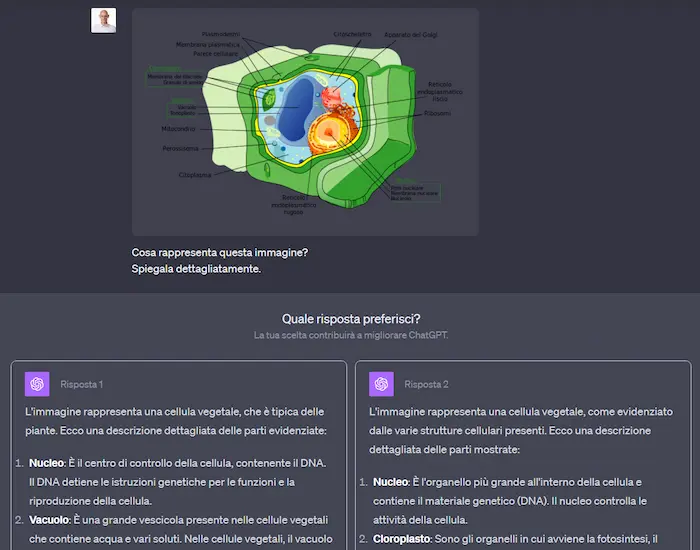

Nell'esempio, lo schema di una cellula viene elaborato e descritto da ChatGPT (GPT-4).

L'abbattimento delle barriere linguistiche

L'AI ci aiuterà ad abbattere barriere importanti, ad esempio quella linguistica.

Nel prossimo futuro potremo parlare la nostra lingua ed essere ascoltati in qualsiasi altra lingua in tempo reale.

E saremo in grado di consumare qualsiasi contenuto audio o video online nella nostra lingua. Brand come Spotify e Google sono già pronti a lanciare le loro soluzioni per concretizzare queste funzionalità per gli utenti delle loro piattaforme.

Già oggi esistono sistemi, ad esempio di HeyGen e Elevenlabs, che consentono di ottenere file multimediali in una grande quantità di lingue. Nel video che segue è possibile visualizzare il risultato di un'elaborazione partendo da un video registrato in lingua italiana.

Pensiamo a cosa significa questo, anche in termini di diffusione della cultura a livello globale. Il video non è perfetto, ma oggi siamo solo all'inizio.

Per un approfondire, consiglio la lettura della FastLetter dedicata a questo argomento, a cura di Giorgio Taverniti.

Conclusioni

Quelle che ho raccontato sono solo alcune novità di un settore che si sta evolvendo ad una velocità mai vista prima, e che probabilmente continuerà a farlo per molto tempo.

Cosa ci servirà per affrontare le sfide che l'intelligenza artificiale ci metterà davanti nel prossimo futuro? Secondo il mio parere ci serviranno tre elementi:

- l'evoluzione tecnologica orientata alla crescita, ma anche all'affidabilità e alla sicurezza;

- una nuova visione di governance, guidata da una collaborazione multidisciplinare;

- cultura.

Nell'ultimo punto siamo tutti coinvolti:

dobbiamo impegnarci per alzare la cultura su queste tematiche, per essere più consapevoli delle tecnologie che utilizziamo e di come queste entrano nella nostra quotidianità.

I prossimi appuntamenti Search On dedicati all'Intelligenza Artificiale

AI per Agenzie e Team Digital

Il 23 gennaio, a Bologna, si terrà la seconda edizione di "AI per Agenzie e Team Digital" della nostra Accademia.

SCOPRI TUTTI I DETTAGLIUna giornata di formazione con me e altri professionisti di Search On: un'opportunità unica per approfondire l'intersezione tra l'AI e il mondo del marketing, dal Prompt Design alle declinazioni dell'AI nella SEO e i casi pratici nell'adv e nel mondo copy.

Segnalo anche La Settimana della Formazione Digitale con "Per cosa useremo DAVVERO l'Intelligenza Artificiale?" che è un'intera settimana gratuita dedicata alla tematica.

E infine l'AI Festival che si terrà il 14 e 15 febbraio 2024 alla Fiera MiCo, Milano!

Discussione tra i membri