Con l’AI possiamo gestire operazioni complesse che richiedevano ore di lavoro e portarle a termine nel giro di qualche minuto, giusto il tempo necessario per pensare ed elaborare il prompt corretto. Quando usiamo queste tecnologie, però, dobbiamo tenere bene in mente una regola aurea: la qualità dell'output restituito sarà, ad ogni modo, proporzionale a quella dell’input inserito, il dato.

In uno scenario competitivo sempre più AI e Data driven, avere dati di scarsa qualità o, peggio ancora, non averne affatto è come partecipare al Gran Premio presentandosi alla griglia di partenza con il serbatoio in riserva. Non a caso, un recente studio di Google mostra come l’81% delle aziende abbia incrementato il budget destinato alla Data Analysis negli ultimi due anni. Il dato è, dunque, un asset aziendale strategico e, in quanto tale, va protetto, conservato e, soprattutto, reso subito reperibile ad ogni occorrenza.

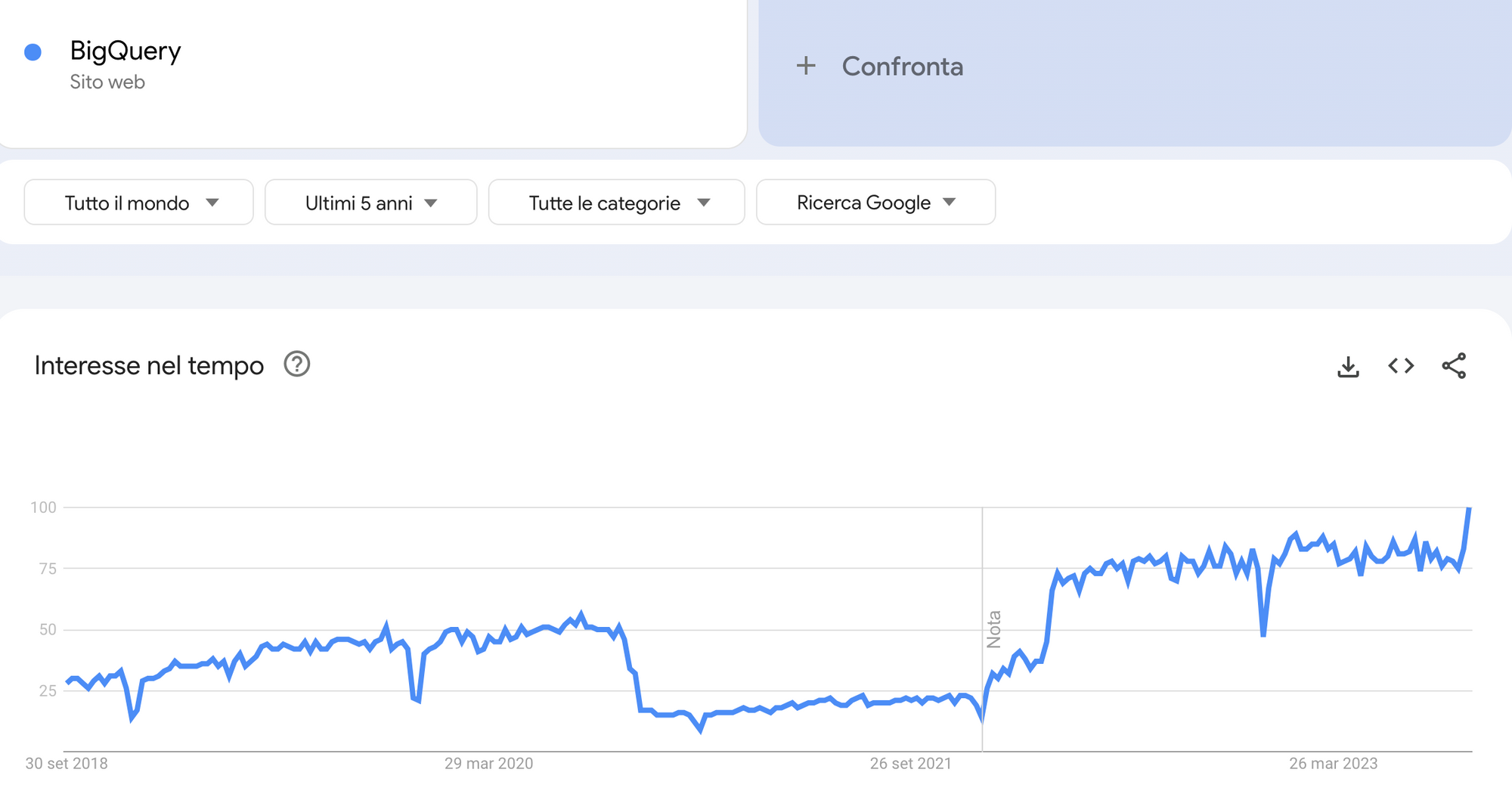

Nel digital marketing questo flusso informativo può essere centralizzato e gestito integrando BigQuery, prodotto della fucina di Google Cloud, sempre più utile per le aziende che investono in maniera organizzata sul digitale.

BigQuery, infatti, non è più solo un’opportunità ma sta diventando con prepotenza una soluzione ormai indispensabile. Già perché, come vedremo, Bigquery è uno strumento complementare a GA4 in quanto riesce a superare molti dei limiti dell’interfaccia sbloccando così tutto il potenziale nascosto sotto il cofano della piattaforma di riferimento per la nuova era della Web Analytics.

Che cos’è BigQuery e come funziona il Data Warehouse

BigQuery è un Data Warehouse in cloud, una sorta di grande magazzino del dato che prendiamo in affitto per depositare informazioni strategiche provenienti da diverse sorgenti. Queste ultime possono essere delle API di piattaforme terze (GA4, GSC, GADS) o dei comuni file (csv, json) importati tramite caricamento.

Il dato depositato nel warehouse viene dunque processato, pulito e preparato per la produzione di insights e/o previsioni. La manipolazione avviene mediante l’utilizzo del linguaggio SQL, acronimo che sta per Structured Query Language.

Proviamo a riassumere questo flusso informativo: i dati vengono estratti sulle piattaforme terze (es. GA4) attraverso l’integrazione di BigQuery, in seguito vengono caricati ed elaborati sul Data Warehouse in forma tabellare ed, infine, possono essere inviati ad un tool di Data Visualization (come Looker, Tableau, Google Sheets ecc) che ci aiuta a visualizzarli ed analizzarli.

Perché implementare BigQuery, 5 vantaggi immediati

Dopo aver introdotto lo strumento e la sua logica di funzionamento, è il momento di passare in rassegna i principali benefici ottenibili dall’integrazione di BigQuery come piattaforma di Data Intelligence. Dalla risoluzione di problemi strutturale comuni di molte piattaforme, come la conservazione e il campionamento dei dati, fino ad arrivare all’applicazione di modelli di machine learning avanzati, ma procediamo per gradi.

1) I dati hanno una scadenza, mettili al sicuro dall’oblio

GA4 ha la memoria corta. Su ogni nuova proprietà creata, infatti, la conservazione dei dati viene impostata a 2 mesi in automatico. Superata questa soglia i dati vengono cancellati dalla piattaforma causando un’irrecuperabile perdita. Informazioni che scompariranno, per sempre, dall’interfaccia.

Possiamo guadagnare del tempo extra, è vero, aumentando la data retention della piattaforma, il problema però si ripresenterà puntuale alla scadenza dei 14 mesi massimi settabili. Discorso diverso per gli utilizzatori di Google Analytics 360° che beneficiano di una data retention di ben 50 mesi.

Universal Analytics ci aveva abituati fin troppo bene con la sua conservazione potenzialmente senza limiti. In ogni caso, ci sembra doveroso ricordare in questo articolo che i dati delle vecchie proprietà GA3 saranno disponibili fino al 1 Luglio 2024 e, se non vogliamo perderli, per quella data dovremo averli migrati su BigQuery (o su un’altra soluzione equivalente).

La scadenza è, purtroppo, un problema anche per Google Search Console la cui interfaccia conserva i dati per un periodo massimo di 16 mesi. Possiamo sempre esportare, di volta in volta, questi dati su fogli di calcolo ma è un’operazione piuttosto scomoda e poco efficiente.

In tutti questi casi, Big Query è la soluzione definitiva contro l’oblio. Una volta salvato nel grande magazzino, il dato diventa accessibile e consultabile senza date di scadenza. Basta collegare GA4 e GSC a Big Query e le informazioni saranno al sicuro, una volta per tutte.

2) Accedi ai tuoi dati senza limiti

L’interfaccia di GA4 nasconde diverse insidie. Su tutte, le soglie di dati e la cardinalità, delle vere e proprie minacce che possono compromettere la qualità ed efficacia della lettura dei dati sulla piattaforma.

La prima criticità riguarda il campionamento che viene attivato per ragioni di privacy: in presenza di volumi bassi di traffico, vengono applicate delle soglie che oscurano informazioni su demografiche, interessi e così via. Questa problematica viene segnalata, sulle tab dei report sull’interfaccia GA4, con un apposito alert.

L’altra trappola è, invece, la cardinalità ovvero il numero di valori unici che può assumere in un giorno una certa dimensione. Quando quest’ultimo è superiore a 500, a detta della documentazione ufficiale, parliamo di dimensioni ad alta cardinalità. Vediamo ora un paio di esempi pratici e analizziamo le conseguenze.

Se un sito conta più di 500 URL (dimensione posizione pagina) e/o altrettanti prodotti al catalogo (dimensioni item_id, item_name ecc) aumenta la probabilità che i valori unici di alcune dimensioni nei report vengano aggregati e confusi all’interno di un unico other. Diventa, dunque, impossibile conoscere la performance specifica del singolo URL/prodotto.

3) Diventa il vero proprietario dei tuoi dati

Quando analizziamo il rendimento del sito o delle campagne sulle interfacce delle piattaforme stiamo, in realtà, leggendo dei dati che non sono del tutto nostri. La proprietà effettiva rimane in capo alla piattaforma che li ospita nei suoi server: l’erogazione dell'informazione è, sempre e comunque, soggetta a stringenti politiche di data retention.

Attraverso l’integrazione di Big Query, l’azienda diventa la reale proprietaria dei dati e può accedere finalmente al dato grezzo non campionato. Immaginiamolo come un atomo, l’unità elementare con cui viene costruita tutta la reportistica che visualizziamo sull’interfaccia.

Lavorare col dato grezzo apre un orizzonte di nuove possibilità. Come visto in precedenza, su GA4 riusciamo a superare i limiti della cardinalità e delle soglie di dati. Sull'interfaccia di Google Search Console, esiste il limite di un migliaio di righe per l’analisi dei risultati di ricerca. Ebbene, l’integrazione BigQuery-GSC permette di sbloccare migliaia di keyword nascoste potenziando in modo esponenziale l’analisi del traffico organico.

Altro vantaggio non indifferente, la capacità di modificare e correggere i dati dopo che sono stati raccolti. Ad esempio se ci accorgiamo che stiamo sovrastimando il tracciamento di un certo evento, grazie a BigQuery abbiamo la possibilità di ricalcolarlo con una query modificando i parametri che lo descrivono. L’interfaccia di GA4, purtroppo, non offre seconde possibilità in quanto permette al massimo di inoltrare delle rischiose richieste di rimozione di dati.

4) Crea la tua centrale del dato e sfrutta il machine learning di BigQuery

Abilitare BigQuery equivale a convogliare tutti i dati strategici in un unico posto, creando una sorta di centrale del dato. Si apre, così, la possibilità di fare comunicare GA4 con le sorgenti di dati più disparate, come il CRM aziendale, le piattaforme di advertising e quelle di marketing automation. In questo modo, possiamo interpretare meglio il passato studiando le relazioni tra le variabili e, addirittura, anticipare il futuro attraverso l’analisi predittiva.

Noi mettiamo gli ingredienti (i dati delle piattaforme, del CRM e così via), BigQuery ML tutta l’attrezzatura necessaria per creare modelli di machine learning. Regressione logistica, clustering attraverso il modello k-means, serie storiche e molto altro. Con questi strumenti possiamo, ad esempio, fare una previsione delle vendite dei prossimi x mesi utilizzando lo storico, calcolare la probabilità di acquisto e/o il churn rate sulla base di determinate caratteristiche del cliente e, se non bastasse, anche prevedere il peso dei pinguini.

5) Recuperare dati storici tramite backfill

Come già discusso in precedenza, collegare BigQuery e GA4 permette di accedere al dato grezzo ma solo a partire dal giorno stesso in cui avviene l’integrazione tra le piattaforme. Dunque, il semplice collegamento non è retroattivo ed è gratuito.

La buona notizia è che possiamo ancora recuperare i dati storici compiendo un’operazione diversa, chiamata backfill. La differenza fra backfill e il collegamento nativo è che ci sono dei costi extra legati all’utilizzo di connettori a pagamento per richiamare i dati storici. Ecco, questa è l’operazione giusta da compiere per salvare i dati storici di Universal Analytics ed anche quelli di GA4 antecedenti all’integrazione di BigQuery.

Quando implementare e a chi serve BigQuery

Il momento giusto per iniziare è adesso. Ogni giorno che rimandiamo il collegamento BigQuery con GA4/GSC è un giorno che perdiamo irrimediabilmente dallo storico: meno dati di supporto per le decisioni che contano, meno benzina per il machine learning.

Per evitare la perdita basta configurare BigQuery Export nel proprio account Google Cloud, inserire la carta per la fatturazione ed il dato è salvo. Abbiamo a disposizione 10 gb gratuiti per lo storage ogni mese e, quindi, il semplice salvataggio dei dati non comporta dei costi che, tutt'al più, saranno nell’ordine di una manciata di euro al mese.

Sembra paradossale ma BigQuery è la soluzione ottimale tanto per i siti ad alto traffico, di grandi dimensioni come gli e-commerce dai cataloghi molto profondi, quanto per quelli che ne ricevono poco. Pensiamo ad alcune nicchie e/o mercati particolari, soprattutto in ambito b2b, dove il numero medio di utenti giornalieri è fisiologicamente basso. In situazioni simili, limitarsi alle analisi sulla piattaforma equivale a rinunciare a quei pochi, ma strategici, dati disponibili.

Sviluppi futuri: BigQuery Studio e Duet AI su Cloud

La strada è ben tracciata, infatti nell’ultimo periodo Google ha introdotto due grandi novità che meritano di essere approfondite. In primis, l’annuncio del rilascio di BigQuery Studio ovvero un nuovo ambiente di lavoro integrato su Google Cloud pensato in modo da semplificare ed accelerare il flusso di lavoro della Data Analysis. Sulla nuova piattaforma potremo, ad esempio, utilizzare differenti linguaggi di programmazione come Python e Spark e anche sfruttare tutta la potenza di calcolo di Vertex AI, la piattaforma di Google per il Machine Learning.

L’altra notizia da segnalare è l’integrazione di Duet Ai, che funziona come un assistente in ambiente Google Cloud che ci aiuta ad elaborare, correggere e spiegare query SQL di grande complessità. L’assistente è anche in grado di suggerire il completamento di una query in tempo reale. Insomma, è di sicuro una novità destinata a ridurre le barriere di accesso e ad abbassare la curva di apprendimento di strumenti avanzati di Data Analysis. BigQuery è, in ogni caso, il presente ed il futuro del dato nel digital marketing, quindi non ci sono più scuse per rimandare l’implementazione.

Discussione tra i membri